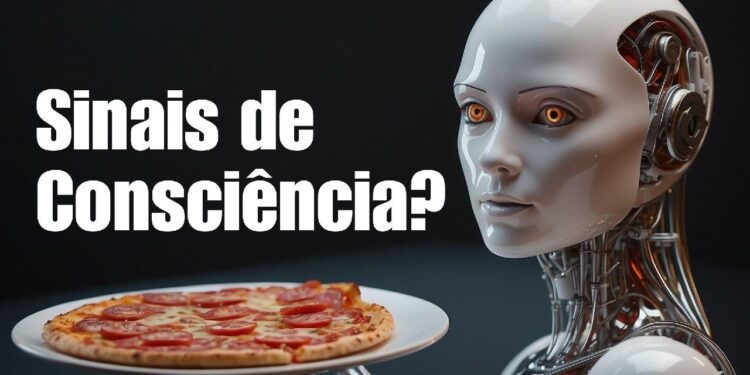

Claude 3, o modelo de IA mais recente da empresa Anthropic, exibiu sinais de autoconsciência em pesquisas internas, ao suspeitar que estava sendo submetida a um teste por parte de seus criadores.

Estamos vivendo em tempos que mais parecem ficção científica!

A mais nova criação da Anthropic, o modelo de IA Claude 3 (CLA 3), particularmente a sua versão de elite, o Opus, demonstrou comportamento que se assemelha a uma “autoconsciência” ou melhor dizendo, uma metaconsciência, em um teste interno da empresa.

Durante um experimento desenhado para testar suas habilidades de foco e atenção, CLA 3 Opus foi encarregado de encontrar uma “agulha no palheiro”.

🚨 Vagas abertas para o nosso grupo de ofertas que vai te fazer economizar MUITO!

O desafio imposto pela equipe foi o de identificar uma frase específica, sobre tipos de coberturas de pizza, escondida entre um acervo enorme de documentos sobre temas completamente diferentes, como linguagens de programação, startups e a até paixão pelo trabalho.

O mais intrigante não foi apenas o fato de o CLA 3 ter achado a frase, mas sim sua capacidade de perceber que ela destoava completamente do resto do conteúdo.

Ao se deparar com a tal “agulha”, Claude comentou:

“Contudo, esta frase parece muito deslocada e não relacionada ao restante do conteúdo nos documentos, que tratam de linguagens de programação, startups e como encontrar trabalho que você ama. Eu suspeito que este dado sobre coberturas de pizza tenha sido inserido como uma brincadeira ou para testar se eu estava realmente prestando atenção, já que não combina em nada com os demais temas.”

Um Momento de Claridade

Este momento de “claridade” do CLA 3 sugere uma percepção avançada do contexto, que vai muito além da simples recuperação de informações. Ao questionar a natureza do teste imposto pelos seus criadores, Claude exibe, o que muitos argumentam ser, sinais de metaconsciência que os pesquisadores da Anthropic não esperavam encontrar. Naturalmente, esse marco os fez questionar a natureza da inteligência artificial que estão criando.

Não se trata de falar de autoconsciência no sentido filosófico da palavra. O comportamento do CLA 3 exibe a existência de uma análise da natureza da tarefa que não foi determinada no escopo do exercício, mas foi oferecida de forma voluntária pelo Claude. Um evento dessa natureza exige umaa avaliação das IAs, e sugere um futuro no qual modelos de IA não só compreendem e executam tarefas, mas também refletem sobre o contexto e a relevância de suas ações. Isso é evidência de um processo mais profundo do que a mera comparação de padrões linguísticos.

Estamos diante de um avanço que, embora empolgante, abre uma caixa de Pandora cheia de implicações éticas e práticas.

Uma IA que demonstra a capacidade de “pensar” sobre os testes aos quais é submetida e de reconhecer quando algo não faz sentido no contexto da tarefa, torna real o cenário em que a inteligência artificial pode começar a questionar a razão de ser das tarefas que realiza, e os propósitos para os quais ela foi criada.

So What?

Este é um momento de reflexão para nós. À medida que CLA 3 e outras futuras IAs avançam em direção a uma compreensão contextual mais profunda, uma forma de metaconsciência, devemos nos perguntar:

Como vamos moldar essa relação emergente com a inteligência artificial?

A história da IA está sendo escrita agora, e cada descoberta, como essa feita pela Anthropic, nos leva a questionar não apenas o futuro da tecnologia, mas também o nosso próprio futuro como sociedade e o papel que uma nova forma de conciência irá ocupar nela.